1. Tổng quan dự án

• Dòng máy chủ mới mang tên mã Vera Rubin NVL144 MGX do NVIDIA phát triển, và Foxconn được báo cáo là “đối tác chính” trong khâu sản xuất.

• Theo thông tin từ báo chí Đài Loan (Taiwan Economic Daily) và các trang tin công nghệ: Foxconn đã bắt đầu phát triển và chuẩn bị sản xuất hàng loạt dòng máy chủ này, với mốc thị trường chính vào nửa cuối năm 2026.

• Foxconn được ước tính có thể chiếm ~60 % thị phần sản xuất/đơn hàng cho Vera Rubin trong năm tới.

________________________________________

2. Những điểm kỹ thuật nổi bật

• Dòng Vera Rubin NVL144 MGX sẽ là bước nâng cấp lớn so với dòng trước đó của NVIDIA (như GB200, GB300).

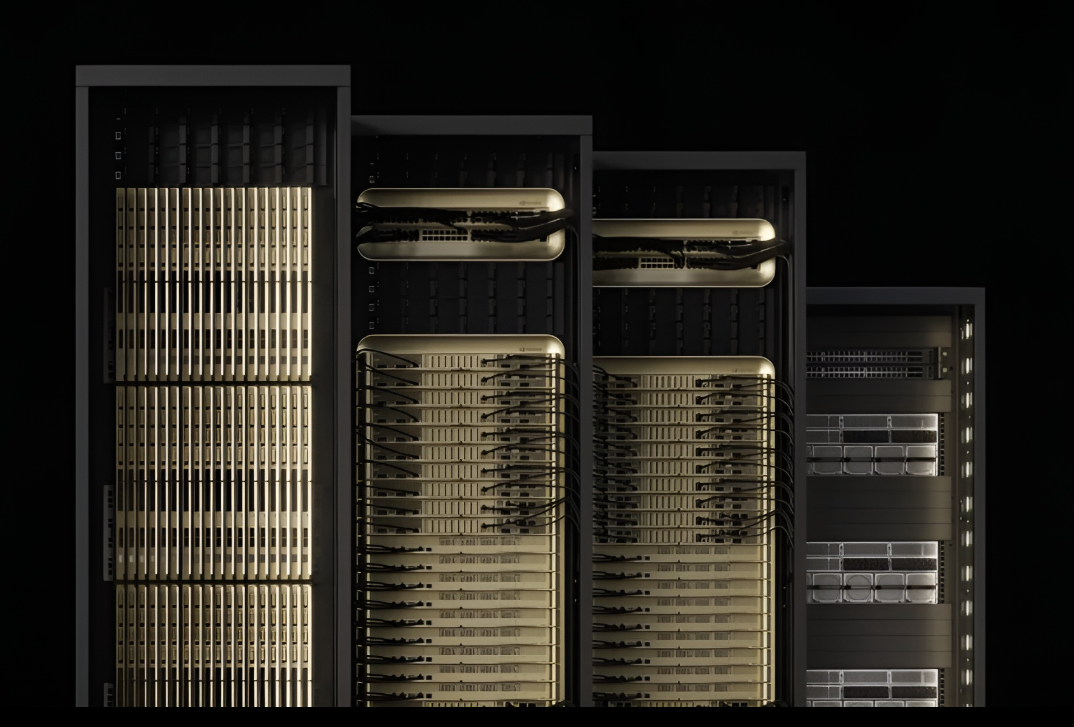

• Hạ tầng máy chủ sẽ hỗ trợ thiết kế rack “gigawatt-scale” — tức các trung tâm dữ liệu với công suất cực lớn, đầu tư cho AI thế hệ mới.

• Các đặc tính kỹ thuật được nhấn mạnh:

o Thiết kế module “tray + midplane” thay vì dây cáp truyền thống để tăng tốc lắp ráp, service.

o Hệ thống làm mát bằng chất lỏng (“100 % liquid-cooled”) cho rack/khay máy chủ.

o Hỗ trợ hạ tầng điện cao áp (ví dụ mô hình 800 VDC) để nâng hiệu quả điện, giảm tải hệ thống vật lý.

• Về thành phần “chip” & hệ thống hỗ trợ:

o NVIDIA đang chuẩn bị các chip “Rubin GPU” và “Vera CPU” (được ghi nhận là đang tiến tới sản xuất) và được thiết kế cho dòng Vera Rubin.

o Các máy chủ Vera Rubin sẽ hỗ trợ các tính năng như NVLink, kết nối tốc độ cao, và bộ nhớ siêu băng thông HBM4.

________________________________________

• Foxconn (công ty mẹ là Hon Hai) được xem là nhà ODM/nhà sản xuất chính cho dòng máy chủ Vera Rubin của NVIDIA.

o Foxconn đã chuẩn bị dây chuyền sản xuất và đầu tư mở rộng cho hạ tầng máy chủ AI.

o Dự kiến Foxconn sẽ đạt sản lượng khoảng 11.000 cabinet máy chủ AI vào 2025, tăng lên ~29.000 vào 2027, và ~40.000 cabinet vào 2028.

• Việc hợp tác kiến trúc, sản xuất với NVIDIA giúp Foxconn giữ lợi thế trong mảng “server cho AI” — một phân khúc đang phát triển nhanh hơn mảng điện tử tiêu dùng truyền thống.

________________________________________

4. Thời gian và mốc quan trọng

• Hiện tại dòng GB200 đã/đang được sản xuất và dòng GB300 bắt đầu ramp up. Foxconn chuẩn bị Vera Rubin NVL144 MGX để bắt đầu sản xuất hàng loạt ở nửa cuối 2026.

• NVIDIA cũng đã công bố rằng chipset Rubin/Vera đang ở giai đoạn “tape-out” (hoàn thiện thiết kế chuẩn bị sản xuất) và đặt mục tiêu sẵn sàng cho năm 2026.

• Với mốc 2026 và 2027 là rất quan trọng cho thế hệ máy chủ mới, Foxconn và NVIDIA đang chạy đua để đáp ứng nhu cầu hạ tầng AI rất “hot” từ các nhà cung cấp điện toán đám mây và dịch vụ AI lớn.

________________________________________

5. Tầm ảnh hưởng và ý nghĩa

• Việc này cho thấy một số xu hướng lớn:

1. Hạ tầng máy chủ AI không còn là “máy chủ truyền thống” nữa mà chuyển sang “rack/cluster chuyên dụng AI” với tiêu chí về hiệu năng, làm mát, điện năng, bộ nhớ rất cao.

2. Nhà sản xuất ODM/EMS như Foxconn đang chuyển dịch mạnh mẽ từ điện tử tiêu dùng sang hạ tầng AI — thị trường với tiềm năng rất lớn.

3. Hợp tác giữa Foxconn và NVIDIA giúp tăng tính cạnh tranh cho NVIDIA cũng như giúp Foxconn giữ vai trò chủ chốt trong chuỗi cung ứng máy chủ AI toàn cầu.

• Với thị phần ~60% trong đơn hàng sản xuất Vera Rubin mà Foxconn có thể chiếm — điều này sẽ ảnh hưởng lớn tới chuỗi cung ứng và công suất máy chủ AI ra thị trường.

• Và từ góc Việt Nam/Đông Nam Á — việc này cũng có ý nghĩa lớn:

o Công ty cung ứng linh kiện, hạ tầng có thể có cơ hội tham gia chuỗi cung ứng máy chủ AI.

o Nhà đầu tư & doanh nghiệp hạ tầng dữ liệu sẽ cần chuẩn bị cho thế hệ máy chủ mới — áp lực về năng lượng, làm mát, chi phí sẽ cao hơn.

o Thời điểm 2026 trở thành mốc “chuyển đổi” quan trọng — nếu bạn hoặc doanh nghiệp bạn đang trong ngành máy chủ hoặc AI, nên theo sát.

________________________________________

• Dù mốc 2026 được nhắc tới nhưng vẫn là dự báo — các vấn đề sản xuất/chip/hạ tầng có thể gây trễ. Ví dụ: quá trình “tape-out” hoặc sản xuất hàng loạt có thể gặp trục trặc.

• Dòng Vera Rubin có thể sẽ rất đắt và dùng tập khách hàng lớn như dịch vụ đám mây, trung tâm dữ liệu quy mô lớn — không phải khách hàng SMB.

• Việc làm mát, điện năng và bố trí rack là thách thức lớn — khi dung lượng GPU và hiệu năng tăng mạnh, chi phí vận hành cũng sẽ tăng.

VN

VN

VN

VN

ENG

ENG