1. Giới thiệu chung & định vị sản phẩm

• FuriosaAI (Hàn Quốc) đã ra mắt sản phẩm máy chủ (server) mang tên NXT RNGD Server, thiết kế dành cho inference AI ở quy mô data center / enterprise.

• Mục tiêu: cung cấp giải pháp inference hiệu năng cao mà vẫn tiết kiệm năng lượng, để dễ tích hợp vào cơ sở hạ tầng hiện hữu (power / cooling) mà không cần “đập đi xây mới” quá nhiều.

• Sản phẩm hiện đang ở giai đoạn sampling / đánh giá với khách hàng toàn cầu, và dự kiến mở bán / đặt hàng chính thức từ đầu năm 2026.

________________________________________

2. Thông số kỹ thuật & kiến trúc

2.1 Kiến trúc tổng thể & hiệu năng

• Mỗi máy chủ NXT RNGD là dạng 4U (kích thước chuẩn data center) và được trang bị 8 card RNGD bên trong.

• Tổng hiệu năng được công bố: 4 petaFLOPS FP8 (hay tương đương 4 petaTOPS INT8) cho mỗi server.

• Hệ thống sử dụng 384 GB HBM3 (với băng thông ~12 TB/s) làm bộ nhớ chính.

• Ngoài ra, máy chủ còn có bộ nhớ hệ thống (DDR5) để phục vụ các tác vụ phụ trợ (như thao tác OS, quản lý).

2.2 Tiêu thụ năng lượng, làm mát & mật độ lắp đặt

• Toàn hệ thống NXT RNGD Server tiêu thụ khoảng 3 kW điện ở công suất định danh.

• Trong khi đó, máy chủ tham chiếu như Nvidia DGX H100 có thể tiêu thụ >10 kW — ví dụ con số 10,2 kW được đề cập.

• Nhờ mức tiêu thụ thấp này, một rack chuẩn (giả sử limit ~15 kW) có thể chứa ~5 máy chủ NXT RNGD, trong khi cùng rack đó nếu dùng DGX H100 có thể chỉ chứa 1 máy.

• Furiosa nhấn mạnh rằng hơn 80 % cơ sở dữ liệu hiện nay dùng làm mát bằng không khí (air-cooled) và giới hạn năng lượng mỗi rack thường ≤ 8 kW — tức nhiều data center không thể dễ dàng hỗ trợ máy GPU lớn tiêu thụ cao. NXT RNGD có ưu điểm là phù hợp hơn với hạ tầng sẵn có.

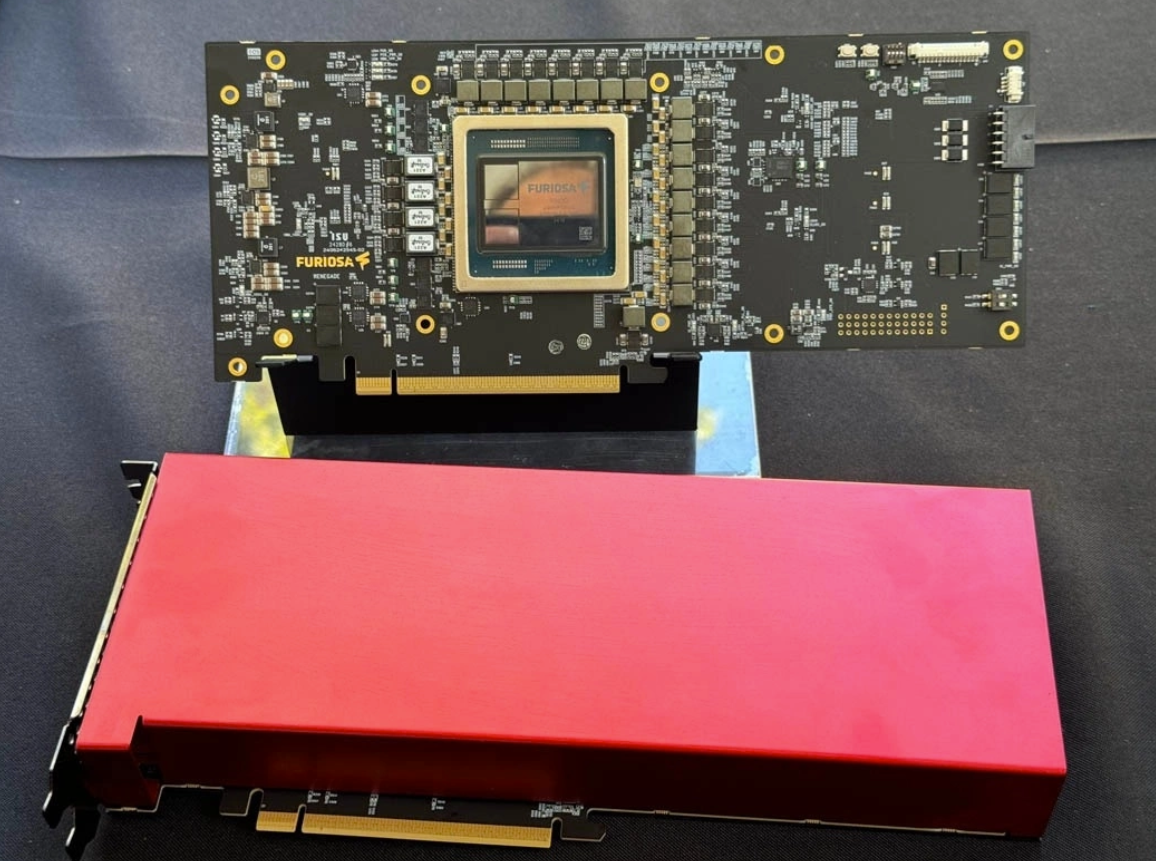

2.3 Chi tiết chip RNGD, kiến trúc nội bộ

• Card RNGD: mỗi card (accelerator) sử dụng quy trình 5 nm của TSMC.

• Mỗi card có 48 GB HBM3 và TDP (thermal design power) ~180 W.

• Hiệu năng mỗi card: ~512 teraFLOPS FP8.

• Kiến trúc chip: sử dụng thiết kế “Tensor Contraction Processor (TCP)” — đây là kiến trúc chuyên biệt cho các phép biến đổi tensor (phổ biến trong các mô hình AI) thay vì cách tiếp cận GPU truyền thống.

2.4 Phần mềm, API & tương thích

• Furiosa cung cấp Furiosa SDK và runtime dành riêng cho RNGD.

• Họ tích hợp sẵn Furiosa LLM runtime và một server tương thích API OpenAI (OpenAI-compatible server) — tức bạn có thể dùng các client / thư viện tuân theo chuẩn OpenAI (ví dụ gọi POST /v1/chat/completions) để giao tiếp với server này.

• Phần mềm hỗ trợ đa dạng dạng dữ liệu: BF16, FP8, INT8, INT4, thậm chí MXFP4 (trong các demo)

• SDK 2025.3 có thêm nhiều tối ưu liên quan đến scaling giữa nhiều chip (multi-chip tensor parallelism), cải thiện hiệu năng, giảm độ trễ (Time-to-First-Token), cải thiện khả năng quan sát / giám sát.

• Hệ thống hỗ trợ container, Kubernetes, các plugin cho môi trường cloud-native.

• Demo nổi bật: Furiosa + OpenAI đã chạy mô hình gpt-oss 120B (open-weight) dùng hai card RNGD, với độ chính xác MXFP4 — chứng minh khả năng chạy mô hình lớn với bộ phần cứng tiết kiệm năng lượng.

________________________________________

3. Ưu điểm nổi bật & thách thức

1. Hiệu năng / Watt cao hơn

Với 3 kW cho 4 petaFLOPS, so với >10 kW trên GPU truyền thống, NXT RNGD hứa hẹn hiệu suất năng lượng vượt trội, giảm chi phí vận hành điện + làm mát.

2. Tương thích cơ sở hạ tầng hiện tại

Do mức tiêu thụ điện và yêu cầu làm mát thấp hơn, server dễ được “nhét vào” các rack hiện có mà không cần cải tạo lớn.

3. Hỗ trợ API OpenAI, dễ tích hợp

Việc cung cấp server tương thích OpenAI API giúp việc port ứng dụng hiện tại trở nên dễ dàng hơn, ít cần thay đổi giao diện lập trình nhiều.

4. Khả năng mở rộng & tối ưu phần mềm liên tục

SDK mới giúp mở rộng giữa nhiều card, tối ưu hóa truyền dữ liệu giữa chip, cải thiện độ trễ — giúp tận dụng phần cứng tốt hơn.

5. Độc lập & bảo mật dữ liệu

Enterprise có thể giữ mô hình và inference trong hạ tầng riêng, không cần phụ thuộc dịch vụ đám mây bên ngoài nếu muốn (về mặt dữ liệu / quyền kiểm soát).

• Hệ sinh thái phần mềm & hỗ trợ: cạnh tranh với hệ sinh thái lớn của GPU (CUDA, các thư viện, cộng đồng) là thách thức. Người dùng phải tin rằng Furiosa SDK & runtime đủ mạnh, ổn định và dễ dùng.

• Khả năng tương thích mô hình / chuyển đổi: mô hình hiện tại thường được thiết kế cho GPU / CUDA. Việc convert, tối ưu cho RNGD (quantization, kernel, cấu trúc) có thể mất công.

• Độ trễ, hiệu ứng đuôi, tình huống đặc biệt: trong inference, những trường hợp “đỉnh cao / đuôi” (tail latencies) rất quan trọng. Furiosa cần chứng minh hiệu năng trong thực tế, không chỉ benchmark trung bình.

• Độ tin cậy, bảo trì, hỗ trợ dài hạn: một startup mới phải xây dựng uy tín về độ ổn định phần cứng, khả năng sửa chữa, cập nhật firmware, hỗ trợ khách hàng quốc tế.

• Khả năng cạnh tranh với các đối thủ khác: như GPU, các AI accelerator khác (Cerebras, Groq, các chip inference tự thiết kế của Google, các nhà lớn khác).

VN

VN

VN

VN

ENG

ENG