• Supermicro cho biết họ đã mở rộng danh mục máy chủ với các hệ thống GPU mạnh mẽ, sử dụng AMD Instinct MI350X/MI355X để hỗ trợ các workload AI & HPC ở quy mô lớn.

• Hệ thống nhắm tới các ứng dụng: huấn luyện mô hình lớn (LLM), inference ở quy mô doanh nghiệp, HPC/trí tuệ nhân tạo kết hợp.

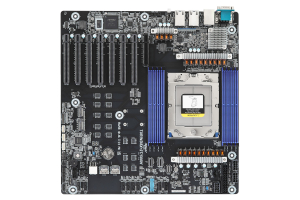

• Một trong các điểm nhấn của Supermicro là “Building Block Solutions” — tức là họ thiết kế các khối hạ tầng (chassis, bo mạch chủ, GPU, mạng) sao cho dễ nâng cấp và triển khai nhanh.

2. Thông số kỹ thuật nổi bật

Dưới đây là các thông số chính của bản máy chủ với MI355X (áp dụng cho mẫu như AS-4126GS-NMR-LCC) và nền tảng liên quan:

• GPU: tới 8 x AMD Instinct MI355X trên một node.

• Mỗi GPU MI355X có bộ nhớ HBM3e dung lượng 288 GB theo một số nguồn và băng thông bộ nhớ khoảng 8 TB/s.

• Hệ thống hỗ trợ CPU: hai socket AMD EPYC (9005/9004 series) với TDP tới ~500 W.

• Bộ nhớ hệ thống: Ví dụ trong AS-4126GS-NMR-LCC hỗ trợ tới 24 DIMM, lên tới ~6 TB DDR5-6400 trong 1DIMM mỗi kênh (1DPC) với CPU EPYC 9005 series.

• Kết nối giữa GPU: sử dụng AMD Infinity Fabric™ Link giúp các GPU liên kết với nhau với băng thông rất cao.

• Hệ thống cooling: dạng liquid cooling (D2C – Direct to Chip) được ưu tiên cho MI355X do công suất và nhiệt lượng lớn.

• Ví dụ về kích thước máy chủ AS-4126GS-NMR-LCC: dạng 4U, chiều sâu ~895.35 mm.

3. Hiệu năng & kết quả benchmark

• Theo tài liệu của Supermicro và các nghiên cứu bên thứ ba, MI355X khi tích hợp trong máy chủ Supermicro có khả năng vượt khoảng 2× throughput so với một số GPU cạnh tranh trong các workload inference/mô hình lớn.

• Ví dụ: Một node với 8 MI355X đã đạt ~2154 tokens/giây/GPU trên workload Llama-3-70B với FP8 (theo nghiên cứu của Signal65) so với ~1918 tokens/giây/GPU của GPU đối thủ B200.

• Điều này cho thấy: nếu bạn huấn luyện hoặc inference mô hình lớn, hệ thống này rất phù hợp vì bộ nhớ lớn GPU giúp giữ mô hình trong GPU mà không cần phân mảnh hoặc truyền dữ liệu nhiều giữa GPU và host.

4. Yêu cầu hạ tầng & vận hành

• Vì công suất và nhiệt lượng cao, bạn cần thiết kế data-center đáp ứng: nguồn điện lớn, làm mát (ưu tiên liquid cooling), bố trí rack sâu và khả năng chịu tải.

• Supermicro cũng đưa ra kiến trúc “cluster validated” – khi muốn triển khai nhiều node, có thể tới hàng chục hệ thống MI355X trong một rack/cluster, với công suất có thể ~80 kW/rack trong một số cấu hình.

• Đối với phần mềm: Hệ thống hỗ trợ stack như ROCm (cho AMD) với các framework như PyTorch, TensorFlow, ONNX Runtime.

5. Nên cân nhắc gì nếu bạn định đầu tư

• Ưu điểm: Bộ nhớ GPU lớn + băng thông cao → phù hợp cho mô hình lớn (LLM) hoặc inference ở quy mô lớn.

o Chi phí đầu tư ban đầu rất cao (GPU + máy chủ + hệ thống làm mát + điện).

o Chi phí vận hành (điện, làm mát) cũng cao — nếu không tối ưu, TCO sẽ lớn.

o Cần hạ tầng hỗ trợ (rack, nguồn, cooling) — không phải tất cả doanh nghiệp đều sẵn sàng.

o Software và vận hành cần có kinh nghiệm để tận dụng triệt để GPU và hệ thống.

• Khi lựa chọn: nếu workload bạn chạy chỉ nhỏ hoặc trung bình (ví dụ inference nhẹ, mô hình nhỏ) thì có thể chọn máy chủ với cấu hình thấp hơn để tiết kiệm. Máy với MI355X phù hợp cho “mô hình lớn + quy mô lớn”.

VN

VN

VN

VN

ENG

ENG